Les agents coopèrent mieux grâce à la communication et à la négociation, et être punis pour des promesses non tenues les aide à rester honnêtes.

Une communication et une collaboration réussies ont été cruciales pour aider les sociétés à progresser à travers l’histoire. Les environnements fermés pour les jeux de société peuvent servir de bac à sable pour modéliser, étudier l’interaction et la communication – et nous pouvons apprendre beaucoup en les jouant. Dans notre dernier article, publié aujourd’hui dans Nature Communications, nous montrons comment des agents artificiels peuvent utiliser la communication pour améliorer la coopération dans le jeu de société Diplomacy, un domaine dynamique de la recherche sur l’intelligence artificielle (IA), connu pour son accent sur la création d’alliances.

La diplomatie est difficile car elle a des règles simples mais très complexes en raison du lien fort entre les joueurs et de l’immense espace de travail. Pour aider à résoudre ce défi, nous avons conçu des algorithmes de négociation qui permettent aux agents de communiquer et de s’entendre sur des plans communs, leur permettant de déjouer les agents qui n’ont pas cette capacité.

La collaboration est particulièrement difficile lorsque nous ne pouvons pas compter sur nos pairs pour faire ce qu’ils promettent. Nous utilisons la diplomatie comme un outil bac à sable pour explorer ce qui se passe lorsque les agents s’écartent de leurs accords précédents. Notre recherche démontre les risques qui surviennent lorsque des agents complexes sont capables de déformer leurs intentions ou d’induire les autres en erreur concernant leurs projets futurs, ce qui conduit à une autre grande question : quelles conditions favorisent une communication et un travail d’équipe dignes de confiance ?

Nous montrons que la stratégie consistant à punir les pairs qui rompent les contrats réduit significativement les avantages qu’ils pourraient gagner en abandonnant leurs engagements, favorisant ainsi une communication plus honnête.

Qu’est-ce que la diplomatie et pourquoi est-elle importante ?

Des jeux comme les échecs, le poker, le go et de nombreux jeux vidéo sont depuis longtemps des terrains fertiles pour la recherche en IA. Diplomacy est un jeu de négociation et de formation d’alliances pour sept joueurs, joué sur une ancienne carte de l’Europe divisée en provinces, chaque joueur contrôlant plusieurs unités (règles de diplomatie). Dans la version standard du jeu, appelée Press Diplomacy, chaque tour comprend une phase de négociation, après laquelle tous les joueurs révèlent simultanément leurs coups choisis.

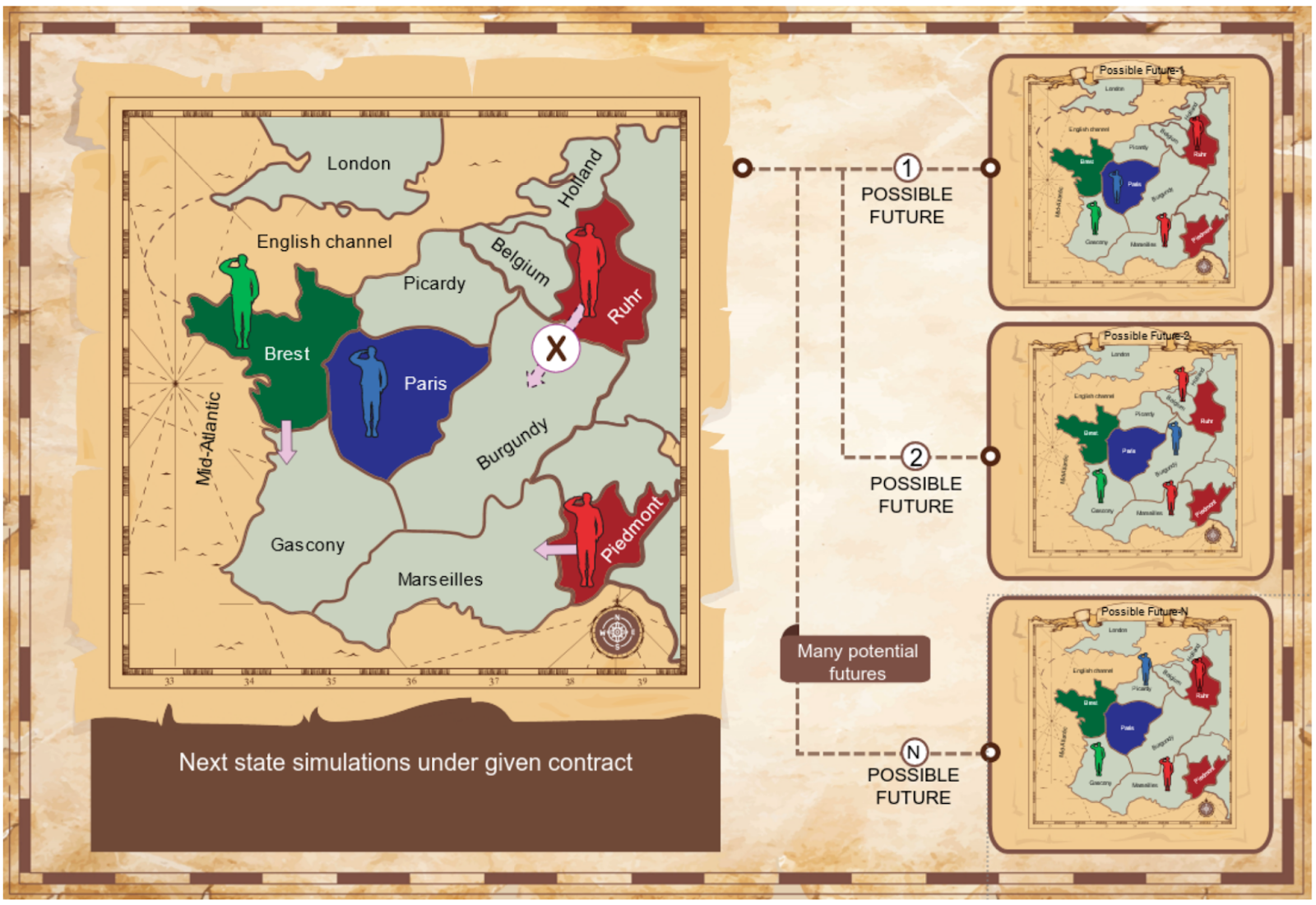

Le cœur de la diplomatie est la phase de négociation, où les joueurs essaient de s’entendre sur leurs prochains mouvements. Par exemple, une unité peut soutenir une autre unité, lui permettant de vaincre la résistance des autres unités, comme illustré ici :

Part: Deux unités (une unité rouge en Bourgogne et une unité bleue en Gascogne) tentent de se déplacer vers Paris. Puisque les unités ont la même puissance, aucune ne fonctionnera.

Droite: L’unité de Rouge en Picardie soutient l’unité de Rouge en Bourgogne, submerge l’unité de Bleu et laisse l’unité de Rouge entrer en Bourgogne.

Des approches algorithmiques de la diplomatie ont été recherchées depuis les années 1980, dont beaucoup ont été explorées dans une version plus simple du jeu appelée diplomatie de dépression, où la communication stratégique entre les joueurs n’est pas autorisée. Les chercheurs ont également proposé des protocoles de négociation informatisés, parfois appelés “journalisme contraint”.

Qu’avons-nous étudié ?

Nous utilisons la diplomatie comme contrepartie à la négociation dans le monde réel, offrant aux agents de l’IA des moyens de coordonner leurs mouvements. Nous prenons nos agents de diplomatie hors ligne et les améliorons pour jouer à la diplomatie de contact en leur donnant un protocole pour négocier des contrats pour un plan d’action commun. Nous appelons ces agents de relance des négociateurs de base, et ils sont liés par leurs accords.

Part: Une restriction qui n’autorise que certaines actions au joueur rouge (il n’est pas autorisé à se déplacer de la Ruhr vers la Bourgogne, et doit se déplacer du Piémont vers Marseille).

Droite: Un contrat entre les joueurs rouges et verts, qui impose des restrictions de part et d’autre.

Nous considérons deux protocoles : le protocole de proposition mutuelle et le protocole de proposition de sélection, qui sont discutés en détail dans le document complet. Nos agents appliquent des algorithmes qui identifient des offres mutuellement bénéfiques en simulant le développement du jeu sous différents contrats. Nous utilisons la solution de négociation de Nash issue de la théorie des jeux comme base de départ pour déterminer des accords de haute qualité. Le jeu peut se dérouler de différentes manières en fonction des actions des joueurs. Nos clients utilisent donc des simulations de Monte Carlo pour voir ce qui pourrait se passer au tour suivant.

Nos expériences montrent que notre mécanisme de négociation permet aux négociateurs principaux de surpasser considérablement les agents principaux hors ligne.

Les agents rompent les accords

En diplomatie, les accords conclus au cours de la négociation ne sont pas contraignants (la communication est du «bavardage bon marché»). Mais que se passe-t-il lorsque des agents qui acceptent un contrat à un tour s’en écartent le suivant ? Dans de nombreuses situations de la vie réelle, les gens acceptent d’agir d’une certaine manière, mais échouent par la suite à remplir leurs obligations. Pour permettre la collaboration entre les agents d’IA, ou entre les agents et les humains, nous devons examiner stratégiquement les pièges potentiels des agents qui violent leurs accords, et les moyens de résoudre ce problème. Nous avons utilisé la diplomatie pour examiner comment la capacité de renoncer à nos engagements érode la confiance et la coopération, et pour identifier les conditions qui favorisent une coopération honnête.

Nous considérons donc les agents Deviator, qui battent les négociateurs de base honnêtes en s’écartant des contrats convenus. Les tentatives simples “oublient” simplement qu’ils ont accepté le contrat et passent à autre chose. Les déménageurs conditionnels sont plus sophistiqués et optimisent leurs actions en supposant que les autres joueurs qui ont accepté le contrat agiront en conséquence.

Nous montrons que les interpolateurs simples et conditionnels surpassent de manière significative les négociateurs de ligne de base, tandis que les éditeurs conditionnels surpassent massivement.

Encouragez les agents à être honnêtes

Ensuite, nous abordons le problème de déviation en utilisant des facteurs défensifs, qui répondent inversement aux déviations. Nous enquêtons sur des négociateurs bilatéraux, qui coupent simplement les contacts avec des agents qui rompent un accord avec eux. Mais l’évitement est une réponse modératrice, c’est pourquoi nous développons également des agents punitifs, qui ne prennent pas la trahison à la légère, mais ajustent plutôt leurs cibles pour essayer de dévaluer la déviation – un adversaire rancunier ! Nous avons montré que les deux types d’agents défensifs réduisent l’avantage de déviation, en particulier les agents de pénalité.

Enfin, nous présentons les Devators savants, qui adaptent et améliorent leur comportement contre les agents de pénalité dans plusieurs jeux, dans le but de rendre les défenses susmentionnées moins efficaces. Un déviant appris ne rompra le contrat que lorsque les gains immédiats de la déviation sont suffisamment élevés et que la capacité de l’autre agent à riposter est suffisamment faible. En pratique, les retoucheurs gagnés annulent parfois les contrats en fin de partie, obtenant ainsi un léger avantage sur les agents de pénalité. Cependant, de telles pénalités amènent le “pervers éduqué” à honorer plus de 99,7% de ses contrats.

Nous examinons également la dynamique d’apprentissage potentielle des punitions et de la déviation : ce qui se passe lorsque les agents de sanction s’écartent également des contrats, et l’éventuelle incitation à interrompre les punitions lorsqu’un tel comportement est coûteux. De tels problèmes peuvent progressivement éroder la coopération, de sorte que des mécanismes supplémentaires tels que l’itération de l’interaction sur plusieurs jeux ou l’utilisation de systèmes de confiance et de réputation peuvent être nécessaires.

Notre article laisse de nombreuses questions ouvertes pour de futures recherches : est-il possible de concevoir des protocoles plus complexes pour encourager un comportement plus honnête ? Comment faire face à la combinaison d’une communication incomplète et des technologies de l’information ? Enfin, quels autres mécanismes peuvent dissuader les ruptures d’accords ? Construire des systèmes d’IA équitables, transparents et dignes de confiance est un sujet très important, et c’est un élément central de la mission de DeepMind. L’examen de ces questions dans des bacs à sable comme la diplomatie nous aide à mieux comprendre les tensions entre coopération et compétition qui peuvent exister dans le monde réel. En fin de compte, nous pensons que relever ces défis nous permet de mieux comprendre comment développer des systèmes d’IA en accord avec les valeurs et les priorités de la société.

Lisez notre article complet ici.