Les générateurs d’images IA, qui créent des scènes fantastiques à l’intersection des rêves et de la réalité, apparaissent dans tous les coins du Web. Leur valeur de divertissement est démontrée par un trésor en constante expansion d’images étranges et aléatoires qui servent de passerelles indirectes vers le cerveau des concepteurs humains. Une simple invite de texte donne une image presque instantanément, à la grande satisfaction de nos cerveaux primitifs, qui ont été câblés pour une gratification instantanée.

Bien qu’apparemment naissant, le domaine de l’art généré par l’IA remonte aux années 1960 avec les premières tentatives utilisant des approches symboliques basées sur des règles pour créer des images artistiques. Alors que l’évolution des paradigmes qui démêlent et analysent les mots a gagné en complexité, l’explosion de l’art génératif a alimenté les débats sur le droit d’auteur, la désinformation et les préjugés, tous embourbés dans le battage médiatique et la controverse. Yilun Du, doctorant au Département de génie électrique et d’informatique affilié au Laboratoire d’informatique et d’intelligence artificielle (CSAIL) du MIT, a récemment développé une nouvelle méthode qui rend les modèles comme le DALL-E 2 plus créatifs et a une meilleure compréhension de la scène. Ici, Du décrit comment ces modèles fonctionnent, si cette infrastructure technique peut être appliquée à d’autres domaines et comment nous traçons la frontière entre l’intelligence artificielle et la créativité humaine.

s : Les images générées par l’IA utilisent ce qu’on appelle des modèles de “diffusion stable” pour transformer les mots en images époustouflantes en quelques instants seulement. Mais pour chaque image utilisée, il y a généralement un être humain derrière. Alors, quelle est la frontière entre l’intelligence artificielle et la créativité humaine ? Comment fonctionnent réellement ces modèles ?

une: Imaginez toutes les images que vous pouvez obtenir sur une recherche Google et leurs motifs associés. C’est le régime alimentaire de ces modèles. Ils ont été formés sur toutes ces images et leurs légendes pour créer des images similaires aux milliards d’images qu’ils ont vues sur Internet.

Disons que le modèle a vu beaucoup de photos de chiens. Il est formé de sorte que lorsqu’il reçoit une invite de saisie de texte similaire à “chien”, il est capable de créer une image qui ressemble beaucoup aux nombreuses images de chiens déjà vues. Maintenant, méthodologiquement, le fonctionnement de tout cela remonte à une très ancienne classe de modèles appelés “modèles basés sur l’énergie”, qui ont vu le jour dans les années 70 ou 80.

Dans les modèles basés sur l’énergie, un paysage énergétique est créé sur les images, qui est utilisé pour simuler la dissipation physique afin de générer les images. Lorsqu’une goutte d’encre tombe dans l’eau et se dissipe, disons, à la fin, vous obtenez juste cette texture uniforme. Mais si vous essayez d’inverser ce processus de dissipation, vous obtiendrez progressivement la goutte d’encre d’origine dans l’eau. Ou supposons que vous ayez une tour de blocs très complexe, et si vous la frappez avec une balle, elle s’effondre en un tas de blocs. Ce tas de blocs est très turbulent et il n’y a pas beaucoup de structure. Pour donner vie à la tour, vous pouvez essayer d’inverser ce processus de pliage pour créer une pile des blocs d’origine.

La façon dont ces modèles génératifs génèrent les images est très similaire, où, au début, vous avez cette image vraiment cool, où vous partez de ce bruit aléatoire, et vous apprenez essentiellement à simuler le processus de comment inverser cela processus de transition. Du bruit à votre photo originale, alors que vous essayez à plusieurs reprises d’améliorer cette photo pour la rendre plus réaliste.

En ce qui concerne la frontière entre l’intelligence artificielle et la créativité humaine, on peut dire que ces modèles sont vraiment formés à la créativité des gens. Internet contient toutes sortes de peintures et d’images que les gens ont déjà créées dans le passé. Ces modèles sont formés pour résumer et construire des images trouvées sur Internet. En conséquence, ces modèles ressemblent beaucoup à des cristaux de ce que les gens ont passé des centaines d’années à créer.

En même temps, parce que ces modèles sont formés à ce que les humains ont conçu, ils peuvent produire des œuvres d’art très similaires à ce que les humains ont fait dans le passé. Ils peuvent trouver des motifs dans l’art créé par des personnes, mais il est très difficile pour ces modèles de créer eux-mêmes des images créatives.

Si vous essayez d’entrer une invite comme “art abstrait” ou “art unique” ou quelque chose comme ça, il ne comprend pas vraiment le côté créatif de l’art humain. Au lieu de cela, les modèles résument ce que les gens ont fait dans le passé, pour ainsi dire, plutôt que de générer un art créatif et fondamentalement nouveau.

Étant donné que ces modèles sont formés sur de vastes étendues d’images provenant d’Internet, bon nombre de ces images sont susceptibles d’être protégées par le droit d’auteur. Vous ne savez pas exactement ce que le formulaire récupère lors de la création de nouvelles images, il y a donc une grande question sur la façon de déterminer si un formulaire utilise des images protégées par le droit d’auteur. Si le modèle est basé, dans une certaine mesure, sur une image protégée par le droit d’auteur, ces nouvelles images sont-elles protégées par le droit d’auteur ? C’est une autre question qui doit être abordée.

s : Pensez-vous que les images générées par les modèles de diffusion symbolisent une sorte de compréhension des domaines naturels ou physiques, dynamiquement ou géométriquement ? Y a-t-il des efforts pour “enseigner” aux générateurs d’images les bases de l’univers que les enfants apprennent très tôt ?

une: Ont-ils, dans le code, une certaine compréhension des domaines naturel et physique ? Je pense vraiment. Si vous demandez à un modèle de créer une configuration de bloc stable, il crée définitivement une configuration de bloc stable. Si vous lui dites de créer une configuration instable de blocs, il semble très instable. Ou si je dis “un arbre au bord d’un lac”, il est presque capable de générer ça.

Dans un sens, ces modèles semblent avoir capté une bonne partie du bon sens. Mais le problème qui nous empêche, encore si loin de vraiment comprendre le monde naturel et physique, est que lorsque vous essayez de créer des combinaisons de mots non répétitives que vous ou moi pouvons facilement imaginer dans notre esprit, ces modèles ne le peuvent pas.

Par exemple, si vous dites : « Mettez votre fourchette sur le dessus de l’assiette », cela arrive tout le temps. Si vous demandez au formulaire de le créer, il peut facilement. Si vous dites, “Mettez une assiette sur une fourchette”, encore une fois, il est trop facile d’imaginer à quoi cela ressemblerait. Mais si vous mettez cela dans l’un de ces modèles plus grands, vous n’obtiendrez jamais une assiette sur une fourchette. Alternativement, vous pouvez placer une fourchette sur le dessus du tableau, où les modèles apprennent à récapituler toutes les images sur lesquelles ils ont été entraînés. Cela ne peut pas vraiment bien généraliser à des combinaisons de mots qu’il n’a pas vues.

Un exemple assez connu est un astronaute à cheval, ce que le modèle pourrait facilement faire. Mais si vous dites qu’un cheval monte un astronaute, c’est toujours une personne qui monte à cheval. Ces modèles semblent capturer de nombreuses corrélations dans les ensembles de données sur lesquels ils sont formés, mais ils ne capturent pas réellement les mécanismes de causalité sous-jacents du monde.

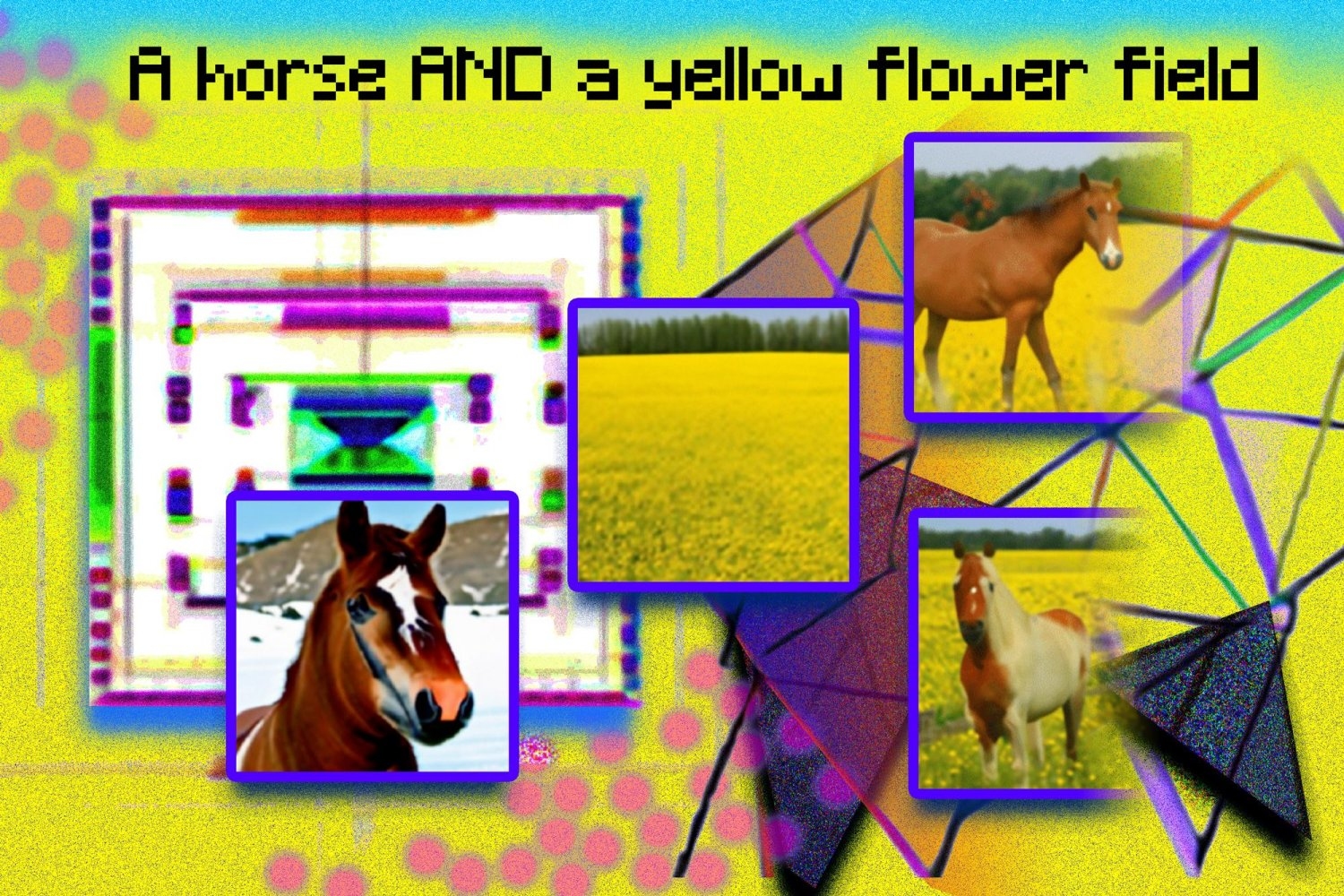

Un autre exemple couramment utilisé est si vous obtenez des descriptions textuelles très complexes telles qu’un objet à droite d’un autre objet, un troisième objet devant et un troisième ou quatrième objet volant à proximité. Il n’est vraiment capable de satisfaire qu’une ou deux choses. Cela peut être en partie dû aux données d’entraînement, car les légendes très complexes sont rares, mais cela peut également indiquer que ces modèles ne sont pas très structurés. Vous pouvez imaginer que si vous recevez des invites en langage naturel très complexes, il est impossible que le modèle puisse représenter avec précision tous les détails du composant.

s : J’ai récemment mis au point une nouvelle méthode qui utilise plusieurs modèles pour créer des images plus complexes avec une meilleure compréhension de l’art génératif. Existe-t-il des applications potentielles pour ce cadre en dehors des champs d’image ou de texte ?

une: Nous nous sommes vraiment inspirés d’une des limites de ces modèles. Lorsque ces modèles donnent des descriptions trop complexes d’une scène, ils sont en effet incapables de créer correctement des images qui leur correspondent.

Une pensée, puisqu’il s’agit d’un modèle unique avec un graphique arithmétique fixe, ce qui signifie que vous ne pouvez utiliser qu’une quantité fixe de calcul pour générer une image, si vous obtenez une invite très complexe, il n’y a aucun moyen d’utiliser plus de puissance de calcul pour générer cela image.

Si vous donniez à un humain une description d’une scène qui faisait, disons, 100 lignes de long par rapport à une longue scène d’une ligne, l’artiste humain pourrait passer plus de temps sur la première. Ces modèles n’ont pas vraiment la sensibilité pour le faire. Nous suggérons donc que, compte tenu des invites très complexes, vous puissiez en fait composer ensemble de nombreux modèles indépendants différents et faire en sorte que chaque modèle individuel représente une partie de la scène que vous souhaitez décrire.

Nous constatons que cela permet à notre modèle de créer des scènes plus complexes, ou celles qui génèrent plus précisément différents aspects d’une scène ensemble. De plus, cette approche peut généralement être appliquée dans une variété de domaines différents. Bien que la génération d’images soit actuellement l’application la plus réussie, les modèles génératifs ont en fait vu toutes sortes d’applications dans une variété de domaines. Vous pouvez les utiliser pour créer différents comportements de robot, compiler des formes 3D, permettre une meilleure compréhension d’une scène ou concevoir de nouveaux matériaux. Vous pouvez configurer plusieurs agents souhaités pour générer le matériel exact dont vous avez besoin pour une application spécifique.

La seule chose qui nous intéressait était les robots. De la même manière que vous pouvez créer différentes images, vous pouvez également créer différentes pistes de bot (piste et calendrier), et en construisant différents modèles ensemble, vous pouvez créer des pistes avec différents ensembles de compétences. Si j’ai une spécification en langage naturel pour sauter ou éviter un obstacle, je peux également créer ces modèles ensemble, puis créer des chemins pour le bot qui peut sauter et éviter un obstacle.

De la même manière, si nous voulons concevoir des protéines, nous pouvons définir différentes fonctions ou aspects – de la même manière que nous utilisons le langage pour définir le contenu des images – avec des descriptions de type langage, telles que le type ou la fonction d’un protéine. Nous pouvons ensuite les enchaîner pour générer de nouvelles protéines capables de remplir toutes ces fonctions données.

Nous avons également exploré l’utilisation de modèles de diffusion dans la création de formes 3D, car vous pouvez utiliser cette approche pour créer et concevoir des ressources 3D. La conception de ressources 3D est généralement un processus très complexe et fastidieux. En superposant différents modèles, la création de formes telles que “Je veux une forme 3D à quatre pieds, avec ce style et cette hauteur” devient beaucoup plus facile, ce qui peut automatiser certaines parties de la conception des ressources 3D.

(balises à la traduction) MIT CSAIL