Avant qu’un modèle d’apprentissage automatique puisse effectuer une tâche, telle que l’identification d’un cancer dans des images médicales, le modèle doit être formé. Les modèles de classification d’images d’entraînement impliquent généralement la visualisation de millions d’exemples d’images collectées dans un vaste ensemble de données.

Cependant, l’utilisation de données d’images réelles peut soulever des problèmes pratiques et éthiques : les images peuvent enfreindre les lois sur le droit d’auteur, violer la vie privée des personnes ou être biaisées contre un groupe racial ou ethnique particulier. Pour éviter ces pièges, les chercheurs peuvent utiliser un logiciel de génération d’images pour générer des données synthétiques afin de former le modèle. Mais ces techniques sont limitées car des connaissances spécialisées sont souvent nécessaires pour concevoir manuellement un logiciel de génération d’images capable de générer des données de formation efficaces.

Des chercheurs du MIT, du MIT-IBM Watson AI Lab et d’ailleurs ont adopté une approche différente. Au lieu de concevoir des programmes de création d’images personnalisés pour une tâche de formation spécifique, ils ont collecté un ensemble de données de 21 000 programmes accessibles au public sur Internet. Ensuite, ils ont utilisé ce vaste ensemble de logiciels de génération d’images de base pour former un modèle de vision par ordinateur.

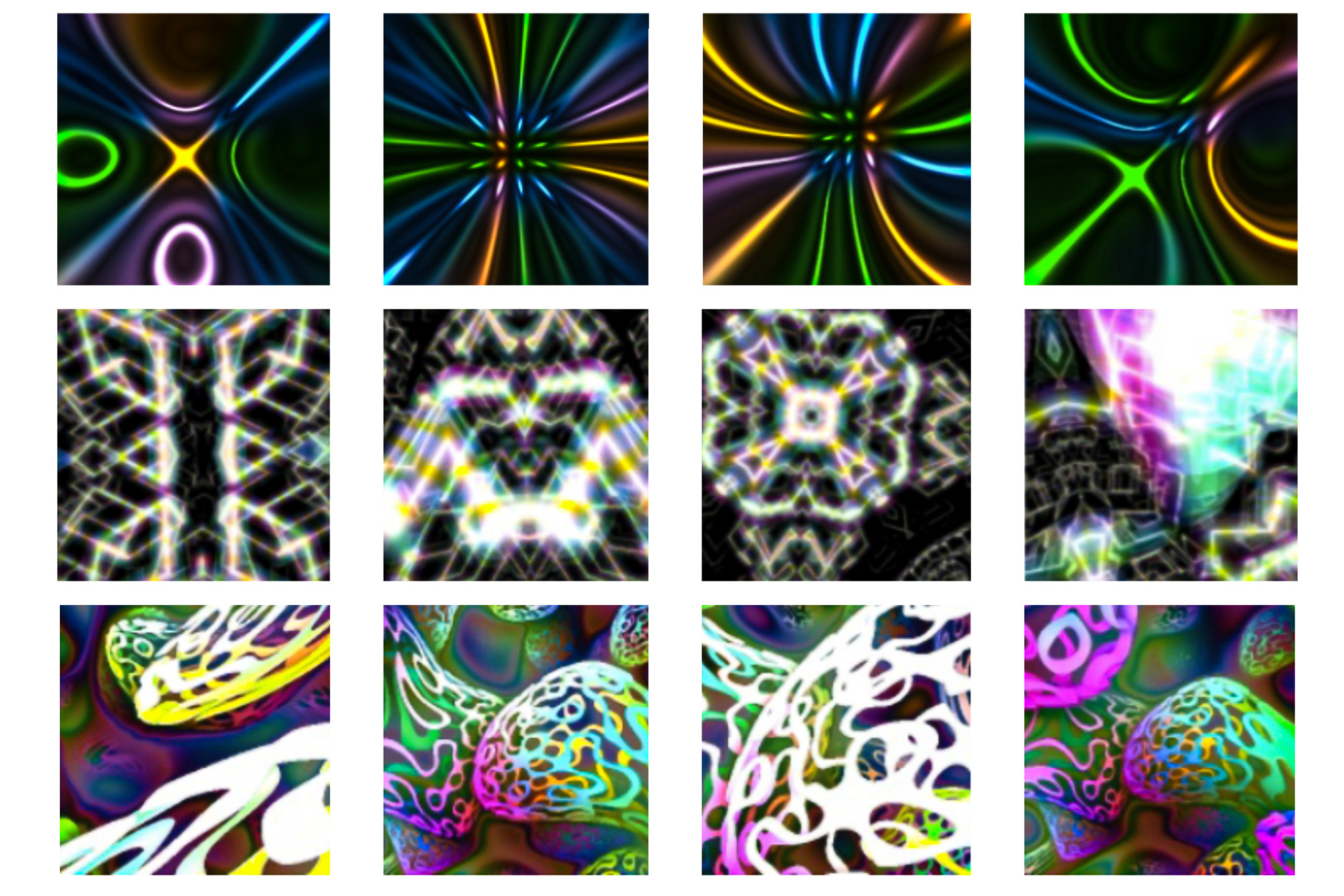

Ces programmes produisent diverses images qui affichent des couleurs et des textures simples. Les chercheurs n’ont ni coordonné ni modifié les programmes, chacun d’entre eux ne comprenant que quelques lignes de code.

Les modèles qu’ils ont formés à l’aide de ce grand ensemble de données de logiciels ont classé les images avec plus de précision que d’autres modèles formés de manière synthétique. Et bien que leurs modèles aient sous-performé les modèles formés sur des données réelles, les chercheurs ont montré que l’augmentation du nombre de programmes d’images dans l’ensemble de données augmentait également les performances du modèle, révélant une voie vers une plus grande précision.

“Il s’avère qu’il vaut mieux utiliser beaucoup de logiciels non saturés que d’utiliser un petit ensemble de logiciels avec lesquels les gens ont besoin de jouer. Les données sont importantes, mais nous avons montré que vous pouvez aller très loin sans données réelles”, a déclaré Manil. Parad, un étudiant diplômé en génie électrique et informatique (EECS) travaille au Laboratoire d’informatique et d’intelligence artificielle (CSAIL) et est l’auteur principal de l’article décrivant la technologie.

Les co-auteurs incluent Tongzhou Wang, un étudiant diplômé EECS au CSAIL; Rogerio Ferris, scientifique principal et directeur, MIT-IBM Watson AI Lab ; Antonio Torralba, professeur de génie électrique et d’informatique à Delta Electronics et membre CSAIL ; Auteur principal Philip Isola, professeur associé EECS et CSAIL ; Avec d’autres chez JPMorgan Chase et Xyla, Inc. La recherche sera présentée à la conférence Neural Information Processing Systems.

Repenser la pré-formation

Les modèles d’apprentissage automatique sont généralement pré-testés, ce qui signifie qu’ils sont d’abord entraînés sur un seul ensemble de données pour les aider à créer des paramètres pouvant être utilisés pour s’attaquer à une tâche différente. Un modèle de classification par rayons X peut être pré-testé à l’aide d’un énorme ensemble de données d’images générées synthétiquement avant d’être entraîné pour sa tâche réelle à l’aide d’un ensemble de données beaucoup plus petit de rayons X réels.

Ces chercheurs ont précédemment montré qu’ils pouvaient utiliser quelques programmes de génération d’images pour générer des données synthétiques pour le pré-entraînement des modèles, mais les programmes devaient être soigneusement conçus pour que les images synthétiques correspondent à certaines propriétés des images réelles. Cela a rendu difficile la mise à l’échelle de la technologie.

Dans le nouveau travail, ils ont utilisé à la place un ensemble de données massif de logiciels de génération d’images désaturées.

Ils ont commencé par collecter une collection de 21 000 programmes de génération d’images sur Internet. Tous les programmes sont écrits dans un langage de programmation simple et se composent de quelques extraits de code, de sorte qu’ils génèrent des images rapidement.

“Ces programmes sont conçus par des développeurs du monde entier pour produire des images qui présentent certaines caractéristiques qui nous intéressent. Ils produisent des images qui ressemblent à de l’art abstrait”, explique Pradad.

Ces programmes simples peuvent s’exécuter si rapidement que les chercheurs n’ont pas besoin de pré-produire les images pour former le modèle. Les chercheurs ont découvert qu’ils pouvaient créer des images et former le modèle simultanément, ce qui simplifiait le processus.

Ils ont utilisé leur ensemble de logiciels de génération d’images Big Data pour pré-entraîner des modèles de vision par ordinateur pour des tâches de classification d’images supervisées et non supervisées. Dans l’apprentissage supervisé, les données d’image sont étiquetées, tandis que dans l’apprentissage non supervisé, le modèle apprend à catégoriser les images sans étiquettes.

Amélioration de la précision

Lorsqu’ils ont comparé leurs modèles précédents avec les derniers modèles de vision par ordinateur précédemment testés à l’aide de données synthétiques, leurs modèles étaient plus précis, ce qui signifie qu’ils placent plus souvent les images dans les bonnes catégories. Alors que les niveaux de précision étaient encore inférieurs à ceux des modèles formés sur des données réelles, leur technique a réduit de 38 % l’écart de performances entre les modèles formés sur des données réelles et ceux formés sur des données synthétiques.

“Il est important de noter que nous montrons que, par rapport au nombre de programmes que vous compilez, les performances évoluent de manière logarithmique. Nous ne saturons pas les performances, donc si nous compilons plus de programmes, le modèle fonctionnera mieux. Il existe donc un moyen d’étendre notre approche, ” dit Mannell.

Les chercheurs ont également utilisé chaque programme de génération d’images individuel pour la pré-formation, dans le but de découvrir les facteurs qui contribuent à la précision du modèle. Ils ont constaté que lorsqu’un programme produisait un ensemble d’images plus diversifié, le modèle fonctionnait mieux. Ils ont également constaté que les images couleur avec des scènes qui remplissaient tout le tableau avaient tendance à améliorer le plus les performances du modèle.

Maintenant qu’ils ont démontré le succès de cette approche de pré-formation, les chercheurs souhaitent étendre leur méthode à d’autres types de données, comme les données multimédias qui incluent du texte et des images. Ils souhaitent également continuer à explorer les moyens d’améliorer les performances de classification des images.

“Il y a encore un écart à combler avec des modèles entraînés sur des données réelles. Cela donne à notre recherche une direction que nous espérons que d’autres suivront.”